HTML页面爬虫如何翻页,在进行网页爬取时,我们经常会遇到需要

翻页的情况,这是因为大部分网站为了优化用户体验,不会在单个页面上展示所有内容,而是将内容分散在多个页面上,这就需要我们的

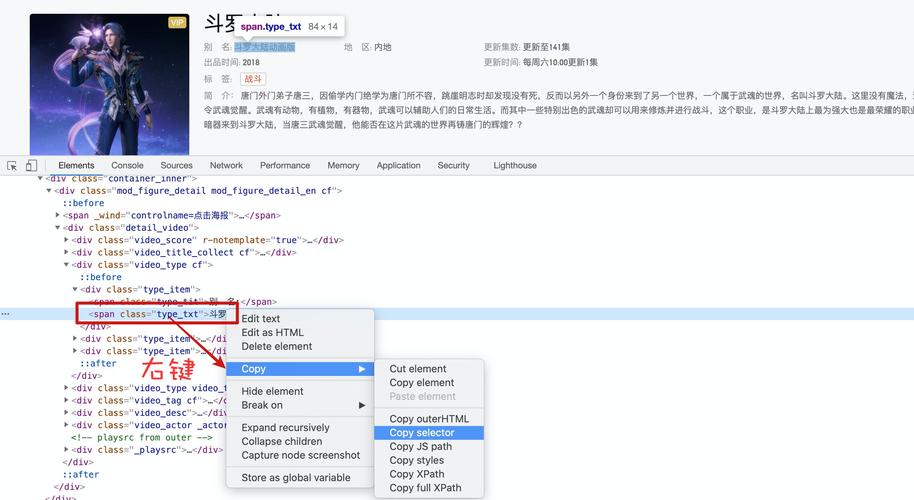

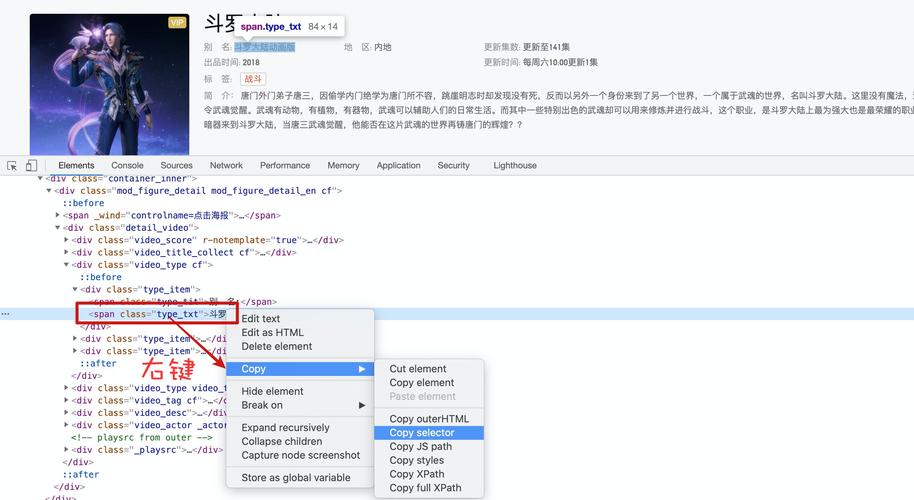

爬虫能够模拟用户翻页的行为,从而获取到所有页面的数据。,以下是实现翻页爬取的一般步骤:,1. 分析网页结构,我们需要分析目标网页的结构,找出其翻页的机制,翻页的机制有两种:,基于URL的翻页:这种类型的翻页,每一页的内容都对应一个不同的URL,第一页的URL可能是

http://example.com/page=1,第二页的URL可能是

http://example.com/page=2等。,基于JavaScript的翻页:这种类型的翻页,所有的内容都在一个页面上,通过JavaScript动态加载不同页的内容,这种情况下,我们需要分析JavaScript代码,找出翻页的触发条件。,2. 构造请求,根据上一步的分析结果,我们可以构造出对应的请求。,如果是

基于URL的翻页,我们可以直接构造出每一页的URL,然后对这些URL进行请求。,如果是

基于JavaScript的翻页,我们可能需要模拟用户的翻页行为,例如点击翻页按钮等,这通常需要使用一些更复杂的工具,如Selenium。,3. 解析响应,对于每一个请求,我们都会得到一个响应,这个响应通常是HTML格式的,我们需要解析这个HTML,提取出我们需要的数据。,这一步通常需要使用HTML解析库,如BeautifulSoup或lxml。,4. 保存数据,我们需要将解析出来的数据保存下来,这可以是保存到文件,也可以是保存到数据库。,以上就是

HTML页面爬虫如何翻页的基本步骤,具体的实现方式会因网站的结构和你的具体需求而有所不同。,

,

,

html页面爬虫如何翻页

版权声明:本文采用知识共享 署名4.0国际许可协议 [BY-NC-SA] 进行授权

文章名称:《html页面爬虫如何翻页》

文章链接:https://zhuji.vsping.com/343239.html

本站资源仅供个人学习交流,请于下载后24小时内删除,不允许用于商业用途,否则法律问题自行承担。

文章名称:《html页面爬虫如何翻页》

文章链接:https://zhuji.vsping.com/343239.html

本站资源仅供个人学习交流,请于下载后24小时内删除,不允许用于商业用途,否则法律问题自行承担。

国外主机测评 - 国外VPS,国外服务器,国外云服务器,测评及优惠码

国外主机测评 - 国外VPS,国外服务器,国外云服务器,测评及优惠码