随着互联网技术不断升级和发展,linux系统作为一款完全开源的操作系统,也在日益被广泛使用。同时,对于其核心部分——内核,也在不断被开发和改进,以适应不同场景下的需求。其中,关于内存管理的研究与实现是非常重要的一环。本文将着重讨论Linux内核中的pagein过程,以加深读者对其内部实现的理解。

一、前置知识

在正式介绍Linux系统中的pagein过程之前,我们需要了解一些相关的背景知识。

内核中的页面调度算法

在Linux操作系统中,内存管理一课通的重要内容就是页面调度。页面调度算法主要用于在有限的物理内存空间下,对进程所请求的虚拟内存页面进行置换。常规的算法有FIFO(先进先出)、LRU(最近最少使用)、Clock算法等等,每种算法都有其优点和不足,根据场景和具体情况进行选择和调优。

内存地址空间(Virtual Memory)

内存地址空间是指计算机程序中的内存分配单元所占的虚拟地址范围,并通过内存管理单元(MMU)将其映射到物理内存地址空间的操作过程。在操作系统中,通常每个进程都有自己独立的虚拟地址空间,这样就可以隔离不同程序之间的内存访问,从而提高系统的稳定性和安全性。

二、pagein过程

pagein过程是指在进程经过内存空间的时候,内核将由虚拟地址映射到的物理地址所对应的页面,从磁盘上载入到内存中的过程。这个过程通常是由操作系统自动完成的,而不需要人工干预。所谓页面是指操作系统对内存空间进行管理的基本单元,大小通常为4KB或者8KB,每个页面都有自己的页框和页表来管理。

在pagein过程中,有一条很重要的命令是fault,也叫缺页中断。当运行进程访问一个地址空间中不存在的页面时,内核将发出一个中断,系统即发生了缺页事件。此时,内核需要将缺失页面所对应的物理页面从磁盘上载入到内存中,并且更新进程的页表,以保证进程能够完成其所需要执行的操作。

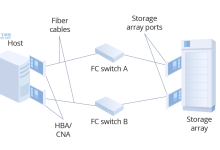

图1:pagein过程的调用流程

(图片来源:http://web.cs.ucla.edu/classes/fall16/cs111/projects/p3.html)

1.缺页处理

缺页中断是pagein过程的入口,它是由MMU硬件自动发起的,通常是由CPU上的MMU硬件设备检测到缺页并通过TRAP/TRAPV指令生成中断(缺页异常)。此时Linux内核会通过page fault handler函数来处理缺页,检测到该页面不在主存中,于是它会调用do_page_fault函数。

2.do_page_fault

do_page_fault是Linux内核用来处理缺页事件的主要核心函数之一。在该函数中,内核首先会判断当前的缺页原因,然后根据不同的情况尝试去恢复进程的执行。如果是由于不存在(not present)或权限(protection)原因造成的缺页事件,内核会调用handle_mm_fault来处理。

例:在Linux系统中,当进程访问不存在的页面时,会发生如下的缺页情况。

图2:不存在页面的情况

3.handle_mm_fault

handle_mm_fault函数是真正的缺页处理函数。它通过计算出目标页在磁盘上的位置,将该页从磁盘读入缓存区,并将该页面映射到进程的虚拟地址空间中。同时,它会将新读入的页面添加到进程的内存空间运行队列和页面LRU链表中,作为后续内存页面置换算法的参考。

通过上述介绍,我们可以发现pagein过程在Linux内核中起到了非常关键的作用。它通过Linux内核提供的缺页中断处理机制,将请求页面从磁盘中读入到内存中,提供了加速进程运行、提高系统稳定性的优秀机制。在实际的运用过程中,我们可以进行针对性地调整页面调度算法、缓存区及LRU链表等参数,以提升系统的性能及稳定性。

相关问题拓展阅读:

- linux下python怎么写爬虫获取图片

linux下python怎么写爬虫获取图片

跟linux有什么关系,python是跨平台的,爬取图片的代码如下:

import urllib.requestimport osimport randomdef url_open(url):

req=urllib.request.Request(url) #为请求设置user-agent,使得程序看起来更像一个人类

req.add_header(‘User-Agent’,’Mozilla/5.0 (windows NT 6.1; WOW64; rv:43.0) Gecko/Firefox/43.0′) #代理IP,使用户能以不同IP访问,从而防止被服务器发现

”’iplist=

proxy_support=urllib.request.ProxyHandler({‘http’:random.choice(iplist)})

opener=urllib.request.build_opener(proxy_support)

opener.addheaders=

urllib.request.install_opener(opener)”’

response=urllib.request.urlopen(req)

html=response.read() 运穗租 return htmldef get_page(url):

html=url_open(url).decode(‘旁兆utf-8’)

a=html.find(‘current-comment-page’)+23

b=html.find(‘>’,a) #print(html)

return htmldef find_imgs(url):

html=url_open(url).decode(‘utf-8’)

img_addrs=

a=html.find(‘img src=’) while a!=-1:

b=html.find(‘.jpg’,a,a+140)if b!=-1:if html!=’h’:

img_addrs.append(‘http:’+html)else:

img_addrs.append(html)else:

b=a+9

a=html.find(‘img src=’,b) for each in img_addrs:

print(each+’我的打印’) return img_addrsdef save_imgs(folder,img_addrs):

for each in img_addrs:#print(‘one was saved’)

filename=each.split(‘/’)with open(filename,’wb’) as f:

img=url_open(each)

f.write(img)def download_mm(folder=’ooxx’,pages=10):

os.mkdir(folder)

os.chdir(folder)

url=””

page_num=int(get_page(url)) for i in range(pages):

page_num=page_num-1

page_url=url+’page-‘+str(page_num)+’#comments’

img_addrs=find_imgs(page_url)

save_imgs(folder,img_addrs)if __name__==’族锋__main__’:

download_mm()

完成

linux pagein的介绍就聊到这里吧,感谢你花时间阅读本站内容,更多关于linux pagein,Linux系统:pagein过程解析,linux下python怎么写爬虫获取图片的信息别忘了在本站进行查找喔。

国外主机测评 - 国外VPS,国外服务器,国外云服务器,测评及优惠码

国外主机测评 - 国外VPS,国外服务器,国外云服务器,测评及优惠码